Guide utilisateur Moztrap

TDF LibreOffice Document Liberation Project Blogs communautaires Weblate Nextcloud Redmine Ask LibreOffice Donner

Introduction

Ce guide décrit étape par étape comment les membres de l'équipe QA peuvent effectuer des tâches basiques dans Moztrap.

Enregistrement et connexion

Pour commencer à réaliser les tests vous devez avoir un compte d'utilisateur. Moztrap prend en charge les identifiants Mozilla Persona et les identifiants natifs. Vous êtes libre d'utiliser celui que vous souhaitez à tout moment. Votre adresse e-mail sera celle utilisée pour identifier votre compte.

Connexion avec OpenID

Après avoir sélectionné cette alternative sur login page:

Connexion avec un compte Wordpress

Pour utiliser cette possibilité vous devez d'abord vous identifier sur Wordpress. Puis saisissez simplement votre identifiant Wordpress comme http://MonNom.wordpress.com dans le champ OpenID pane et cliquez sur ok

Connexion avec le Mozilla Persona

Mozilla Persona est une façon générique de se connecter non réservée à Moztrap mais également à d'autres applications Web. Si vous savez déjà ce qu'est un Persona et que vous souhaitez vous connecter avec dans Moztrap, cliquez simplement sur le bouton Sign in (figure 1) et suivez les instructions dans la fenêtre pop-up.

Enregistrement natif dans Moztrap

Pour vous connecter de façon native, vous devez vous enregistrer sur Moztrap. Après l'enregistrement, une confirmation par mail vous sera envoyée dans la boîte mail utilisée, cliquez alors sur le lien à l'intérieur pour activer votre compte.

Permissions par défaut

Avec n'importe laquelle des méthodes énoncées ci-dessus, la communauté LibreOffice vous assigne un compte en tant que [QA/Testing/Test_Cases_Contribution|Tester]], vous pouvez vous connecter à votre compte Moztrap et démarrer vos tests sans autre demande de permission.

Exécuter les tests

Cette section va donner une description détaillée des étapes afin de vous montrer comment exécuter les tests dans Moztrap.

Sélectionner les tests et l'environnement

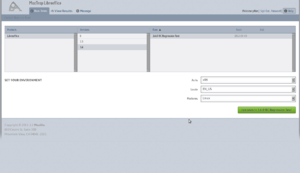

- Dans l'onglet Run Tests, sélectionnez :

- Product - habituellement Libreoffice est le seul choix

- Versions - normalement cela doit être la dernière version qui nécessite des tests approfondis

- Runs - choisissez soit des tests de régression ou des tests de fonctionnalités en fonction de ce que vous souhaitez exécuter

- Dans la section "SET YOUR ENVIRONMENT", sélectionnez les éléments de votre environnement reflétant votre environnement réel de test.

- Arch

- Locale

- Platform

- Appuyez sur le bouton "Run tests in ..." pour poursuivre.

Sélectionner un cas test

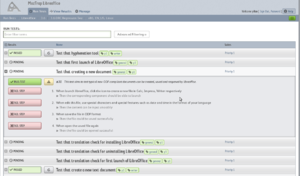

Comme le montre la figure 3, Moztrap a une interface intégrée pour afficher et exécuter les cas test dans une session de tests sélectionnée.

Dans l'interface, il est facile de voir tous les cas test listés en lignes. Cliquer sur n'importe laquelle de ces lignes va étendre la description détaillée et l'exécution dans l'interface de ce cas test spécifique et le sélectionner.

Comme mentionné ci-dessus, Moztrap affiche tous les cas tests de façon paginée. Moztrap permet donc aux testeurs de filtrer les cas test parmi l'ensemble de cas test d'une session de cas test particulière. La méthode habituelle est de filtrer les cas test en cliquant le drapeau ajouté au Nom du test. Par exemple, en cliquant sur le drapeau p1, cela affichera tous les cas tests p1 et en cliquant sur le drapeau writer, cela filtrera tous les cas test writer disponibles. Un filtrage plus élaboré peut être réalisé soit en saisissant "RUN TESTS" dans le champ de filtre, soit en cliquant sur le bouton Advanced Filtering>> situé tout en haut de la liste de cas test.

De plus, vous remarquerez sans doute que certains cas test sont déjà marqués PASSED ou FAILED dans les champs Results alors que vous ne les avez jamais exécutés. Cela signifie en fait que les cas test ont déjà été exécutés par d'autres personnes ayant exactement le même environnement que le vôtre, et vous ne souhaitez sans doute pas répéter exactement le même ensemble de test. Les cas test ayant Pending dans le champ Results sont sans doute plus intéressants à exécuter.

Finalement les cas test p1 (haute priorité) sont les plus importants et concernent les fonctions basiques qu'une version de LibreOffice fournit. Les testeurs sont invités à terminer les cas test p1 dans la plupart des scénarios et phases de tests.

Exécuter les tests et rapporter les résultats

Après avoir sélectionné un cas test en étendant la ligne du cas test, vous verrez les instructions décrivant comment le test doit être exécuté. Suivez simplement les étapes de la description et enregistrez le résultat que vous observez, c'est tout ce que vous avez à faire ici. Pour enregistrer différents résultats, cliquez sur le bouton correspondant tout en ajoutant de courts commentaires :

- bouton PASS TEST - cliquez sur ce bouton lorsque toutes les étapes décrites dans le cas tests sont exécutées correctement.

- bouton FAIL STEP - cliquez sur ce bouton quand une étape particulière décrite dans le test a échoué, le test en entier sera alors marqué échoué. Vous devez ajouter une explication sur la façon dont le test a échoué dans la zone de texte. Facultativement, vous pouvez aussi donner un URL Bugzilla où un bug a été enregistré.

- bouton Invalid - ce bouton apparaît en regard du bouton PASS TEST comme un point d'exclamation sur fond jaune. Cliquez dessus lorsque le cas test contient des étapes qui ne sont pas claires, incorrectes ou sont incompréhensibles. Les gestionnaires des cas test actualiseront ces tests en fonction de votre rapport. Vous devez également ajouter une brève explication afin de documenter le fait que vous marquiez le cas test Invalid.

Créer de nouveaux cas test

Obtenir l'authentification

Dans le contexte de Moztrap, pour créer de nouveaux cas test directement, vous devez être au moins un créateur de tests. Il y a d'autres façons pour que vos tests soient acceptés, mais elles sont en dehors du sujet traité ici.

Ajouter de nouveaux cas test

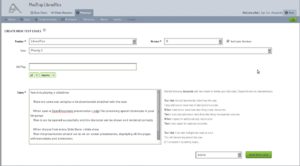

Comme l'indique la figure 4 naviguer dans l'onglet Manage->Cases affichera la mise en page pour gérer les cas test.

Pour ajouter un seul cas test, cliquez sur le bouton + create a test case en haut à droite de la page. Une page de création de test (figure 5) vous permet de saisir les informations requises. Les indications ci-dessous donnent une idée basique de remplissage des champs :

- Product - Le produit auquel appartient le cas test.

- Version - La version du produit de ce cas test.

- And Later Versions - Crée une version de cas test pour la version du produit spécifiée ainsi qu'une version du cas pour toutes les autres versions ultérieures du produit (ex.: si les versions 3, 4 et 5 existent pour ce produit et que vous avez spécifié la version 4, ce cas test sera créé pour la version 4 et 5)

- Suite - La suite existant à laquelle vous souhaitez que ce test soit rattaché. Vous pouvez également ajouter des cas à la suite plus tard.

- Name - Le nom résumé du cas.

- Description - Toute description, pré-condition, liens ou remarques à associer à ce cas test. Ce champ est affiché lors de l'exécution du test. La syntaxe Markdown syntax est prise en charge.

- Add Tags - Ajouter des drapeaux à ce cas. Appuyez sur Entrée après chaque drapeau pour voir l'étiquette du drapeau affichée. L'Auto-complétion est active pour les drapeaux existants.

- Add Attachment - Vous pouvez attacher des fichiers, qui peuvent aider à exécuter le test, au cas (ex : images, audio, video, etc.)

- Instruction / Expected - Les instructions du tests et le résultat attendu correspondant. Vous pouvez choisir de mettre toutes les instructions/attentes en une seule étape, ou les séparer en étapes individuelles. Lors de l'exécution du test, vous aurez alors l'option de marquer les étapes ratées à une étape spécifique, c'est donc sans doute une meilleure approche. La syntaxe Markdown syntax est prise en charge.

Après avoir complété les champs requis, cliquez sur le bouton save test case pour l'enregistrer. Par défaut le cas test est activé pour une utilisation immédiate. Alternativement, vous pouvez marquer le test comme 'disabled' (désactivé) ou 'draft' (brouillon) s'il doit être complété ultérieurement.

Ajouter un ensemble de cas test

Comme la figure 4 l'indique, naviguer jusqu'à l'onglet Manage->Cases affiche la mise en page de gestion des cas tests.

La création d'un ensemble de cas test ne présente pas de grande différence conceptuelle avec l'ajout de cas test uniques. Disons que lorsque vous avez une douzaine de cas test, au lieu de cliquer sur le bouton + create a test case encore et encore afin de les ajouter un par un, la création d'un ensemble de test vous permet de créer de nombreux cas test sur une seule page et de les soumettre commodément.

Par rapport à la figure' 3, pour ajouter un ensemble de cas test, cliquez sur le bouton ++... sur le côté gauche de + create a test case. Une page de création d'ensemble de tests s'affiche alors comme le montre la figure 6. Le champ le plus important est que vous devez suivre quelques règles syntaxiques pour organiser ces cas afin que Moztrap soit en mesure de comprendre comment les répartir en cas de tests individuels ainsi que leurs étapes. Actuellement le format Gherkin-esque est la seule syntaxe qui est prise en charge.

Maintenir les cas test

Obtenir l'authentification

Dans le contexte de Moztrap, pour éditer, cloner ou supprimer des cas test directement, vous devez être au moins Test Manager. À côté, il y a d'autres façons d'accepter vos suggestions de mise à jour de cas test, mais elles sont en dehors de ce qui est traité ici.

Éditer, sélectionner un environnement, cloner et supprimer des cas test

Après vous être identifé comme test manager, il vous sera possible de voir les icônes de gestion des cas test qui sont situées sur le côté gauche du résumé du cas test, dans la vue affichée à la figure 4. De gauche à droitre, elles sont éditer, sélectionner un environnement, cloner et supprimer.

- Edit - vous permet d'actualiser un cas test existant.

- Environment - vous permet d'affiner la liste des environnements pour un cas test donné. Avec cette fonction, vous pouvez décocher tout environnement auquel vous ne souhaitez pas appliquer le cas test. Vous pouvez également ajouter des environnements qui auraient été précédemment supprimés. Cochez ou décochez les éléments pour les inclure ou les exclure. Les environnements sont un élément intéressant et le manuel Moztrap est utile pour les comprendre complètement.

- Clone - vous permet de copier le cas test.

- Delete - vous permet de supprimer un cas test de toutes les versions auxquelles il est attaché.

Vérifier les résultats des tests

Un résultat de tests stocke les résultats de l'éxécution d'un simple test à un ensemble de tests, dans un environnement particulier, par un testeur particulier.

Vérifier les résultats de tests est direct.

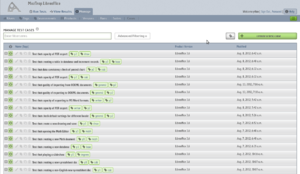

Pour avoir un aperçu des résultats d'une session de tests, comme montré à la figure 7 :

- Naviguez jusqu'à l'onglet View Results

- Cliquez sur Test Runs dans le sous-menu

Les icônes Pass/Fail/Unclear ainsi que les statistiques seront affichées dans la dernière colonne de la vue. Vous pouvez cliquer sur l'icône en triangle au début de chaque test pour étendre l'affichage d'informations détaillées, dans lequel cliquer sur le bouton See related test cases affiche tous les résultats de test d'un cas test particulier dans cette session de test (figure 8).

Alternativement, pour avoir un aperçu du résultats de tous les cas test, comme affiché à la figure 8 :

- Naviguez jusqu'à l'onglet View Results

- Cliquez sur Test Cases dans le sous-menu

Les icônes Pass/Fail/Unclear ainsi que les statistiques seront affichées dans la dernière colonne de la vue (figure 9). Lorsque le test a été exécuté, vous pouvez cliquer sur les icônes Pass/Fail/Unclear pour atteindre exactement la même page.